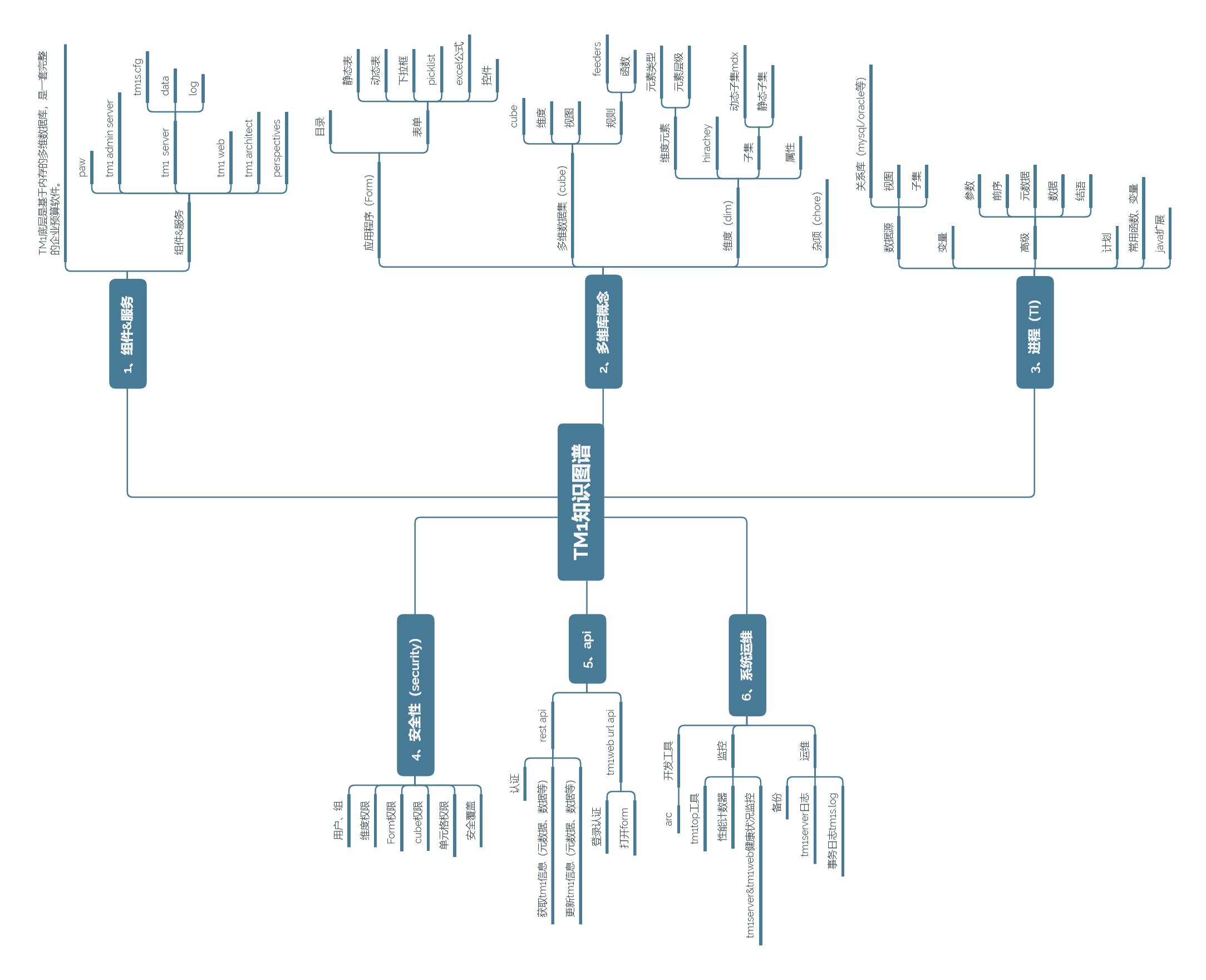

参考文档:廖雪峰的官方网站-本地快速安装运行史上最强开源LLaMa3大模型

1 部署Ollama工具

Ollama是一个开源的 LLM(大型语言模型)服务工具,可以在它上边部署、运行各种开源大模型。

1.1 安装Ollama

可以在Ollama官网、github、中文网 下载windows安装包OllamaSetup.exe,双击安装即可完成。

安装路径默认:C:\Users\用户名\AppData\Local\Programs\Ollama

1.2 启动Ollama

安装完ollama会自动启动,可以访问 http://localhost:11434/ 来验证:

后续可以双击Ollama图标启动,也可以使用cmd命令行手动启动服务:

ollama serve

2 部署llama3大模型

llama3是MetaAI开源的一代大语言模型。安装Ollama之后,可以通过Ollama来部署、运行、使用llama3.

2.1 使用ollama安装、运行llama3

安装了ollama之后,可以执行以下命令行启动llama3,首次运行会自动安装:

ollama run llama3

接下来就可以用命令行和llama3对话了:

模型文件默认位置:C:\Users\用户名\.ollama\models

2.2 ollama其他常用命令

查看所有模型:

ollama list

删除模型:

ollama rm llama3

2.3 安装llama3-中文微调版

由于llama3官方版本中文支持不太理想,许多人对其进行了针对中文的微调,可以去huggingface.co(需要魔法)或它的镜像地址下载。

2.3.1 下载模型

选择对应的llama3中文微调版本模型,下载gguf文件(GGUF格式是llama.cpp团队搞的一种模型存储格式,一个模型就是一个文件,方便下载):

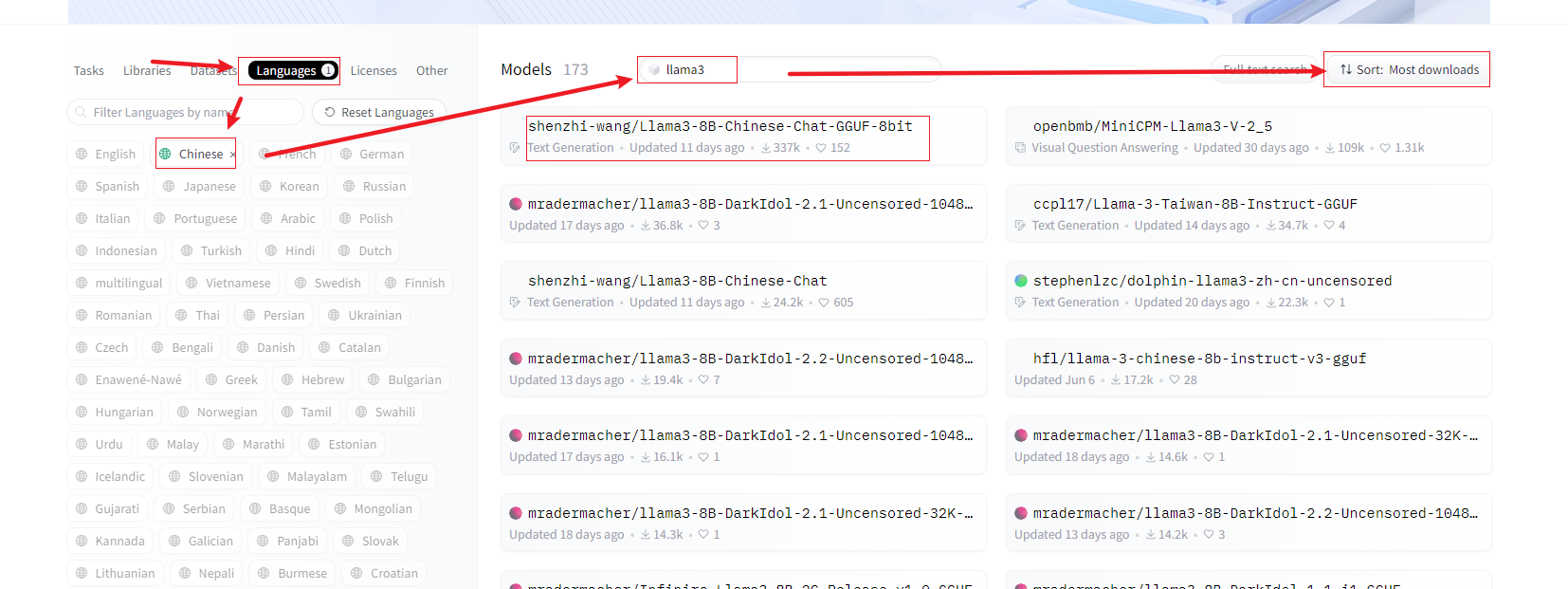

语言选择Chinese,搜索llama3,可以按需排序:

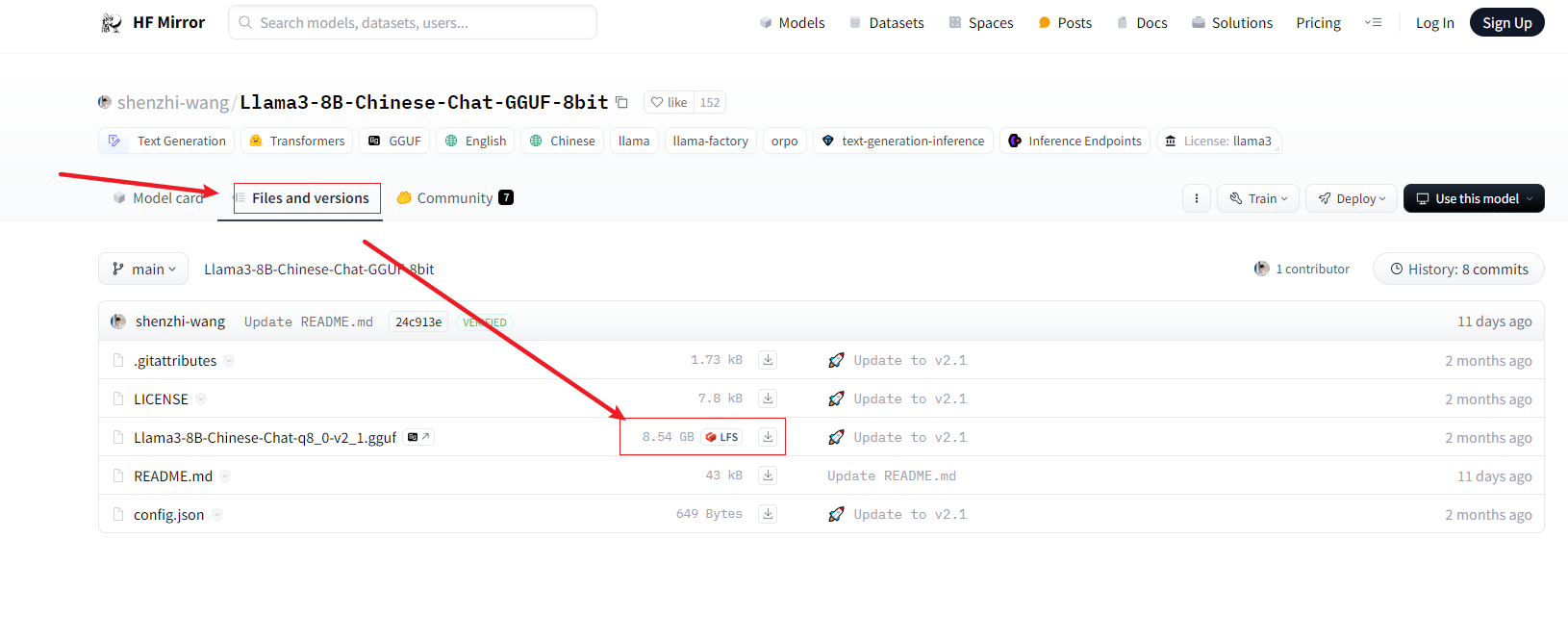

选择某一个模型进去,选择files and versions,下载那个gguf文件:

2.3.2 导入模型

编写一个配置文件,随便起个名字,如 Llama3-8B-Chinese-Chat-config.txt, 其中的gguf文件路径记得替换:

FROM "E:\software\Ollama\Llama3-8B-Chinese-Chat-q8_0-v2_1.gguf"

TEMPLATE """{{- if .System }}

<|im_start|>system {{ .System }}<|im_end|>

{{- end }}

<|im_start|>user

{{ .Prompt }}<|im_end|>

<|im_start|>assistant

"""

SYSTEM """"""

PARAMETER stop <|im_start|>

PARAMETER stop <|im_end|>

使用以下cmd命令导入模型,记得替换txt文件路径:

ollama create llama3-cn -f E:\software\Ollama\Llama3-8B-Chinese-Chat-config.txt

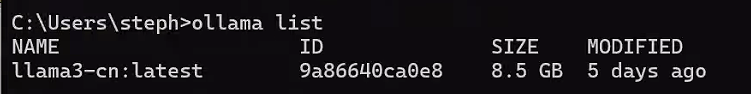

完成之后可以执行 ollama list 查看所有模型。

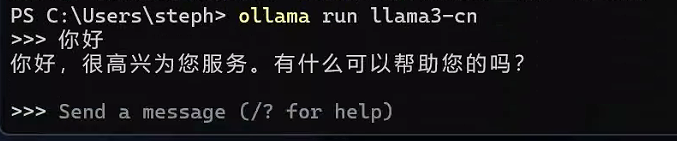

接下来可以执行ollama run llama3-cn来使用该模型。

3 部署Open WebUI环境

用Docker可以比较方便的部署、运行Open WebUI. Open WebUI可以在web端访问本地运行的大模型,比命令行端方便。

3.1 安装docker desktop

官网(需要魔法)下载docker desktop,或者阿里云镜像下载。双击Docker Desktop Installer.exe安装即可;

docker路径 C:\Users\用户名\AppData\Local\Docker\wsl\data

安装后重启会提示一些问题,应该是没有开启Hyper-V。

3.2 开启Hyper-V并升级wsl

参考:https://blog.csdn.net/m0_37802038/article/details/129893827

如果是非win11家庭中文版:直接打开控制面版--程序--程序和功能--启用或关闭windows功能 ,勾选Hyper-V即可:

如果是win11家庭中文版,控制面板可能找不到Hyper-V,就需要创建一个文本并以 .cmd为后缀命名(比如:开启hyper.cmd),复制以下内容贴进去:

pushd "%~dp0"

dir /b %SystemRoot%\servicing\Packages\*Hyper-V*.mum >hyper-v.txt

for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\servicing\Packages\%%i"

del hyper-v.txt

Dism /online /enable-feature /featurename:Microsoft-Hyper-V-All /LimitAccess /ALL

右键该文件“以管理员方式运行”,重启电脑,即可开启hyper-V。

重启之后如果依然报错,根据提示,可能是wsl版本不是最新的,管理员方式运行power shell,然后更新wsl即可:

wsl --update

3.3 验证docker

cmd命令查看docker安装的版本看是否安装成功:

docker --version

3.4 配置国内镜像源

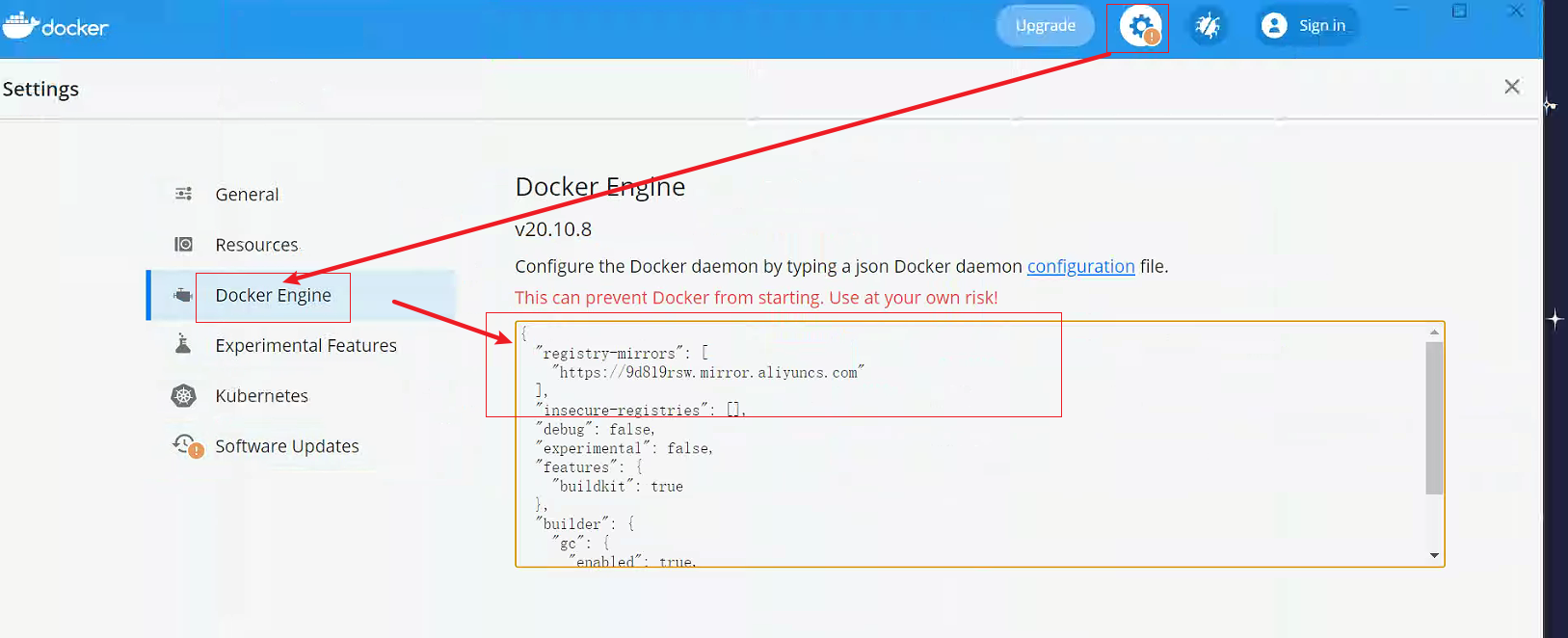

docker默认使用官方镜像源,国内访问需要魔法且速度较慢,建议切换到国内镜像源(比如阿里云):

双击打开docker desktop,设置,Docker Engine,添加以下内容:

"registry-mirrors": [

"https://9d819rsw.mirror.aliyuncs.com"

]

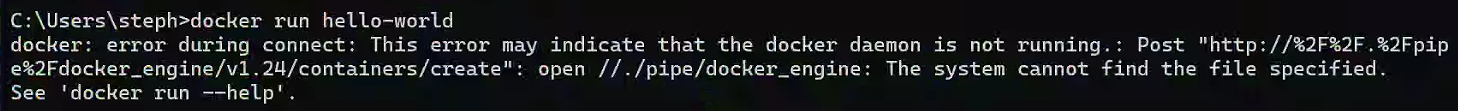

cmd命令行运行hello-world进行验证:

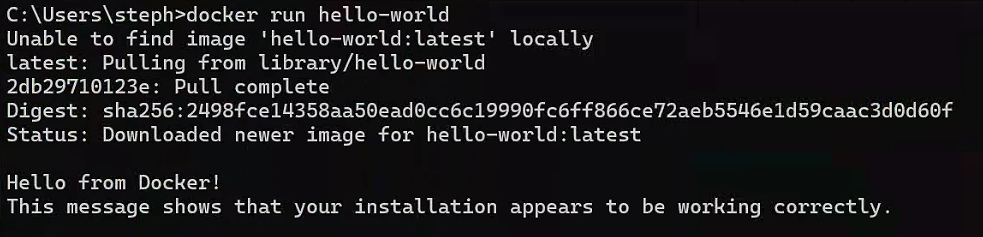

docker run hello-world

该提示说明没有运行docker守护进行,双击刚刚安装的docker desktop,然后再执行该命令,第一次会自动下载镜像,稍等片刻:

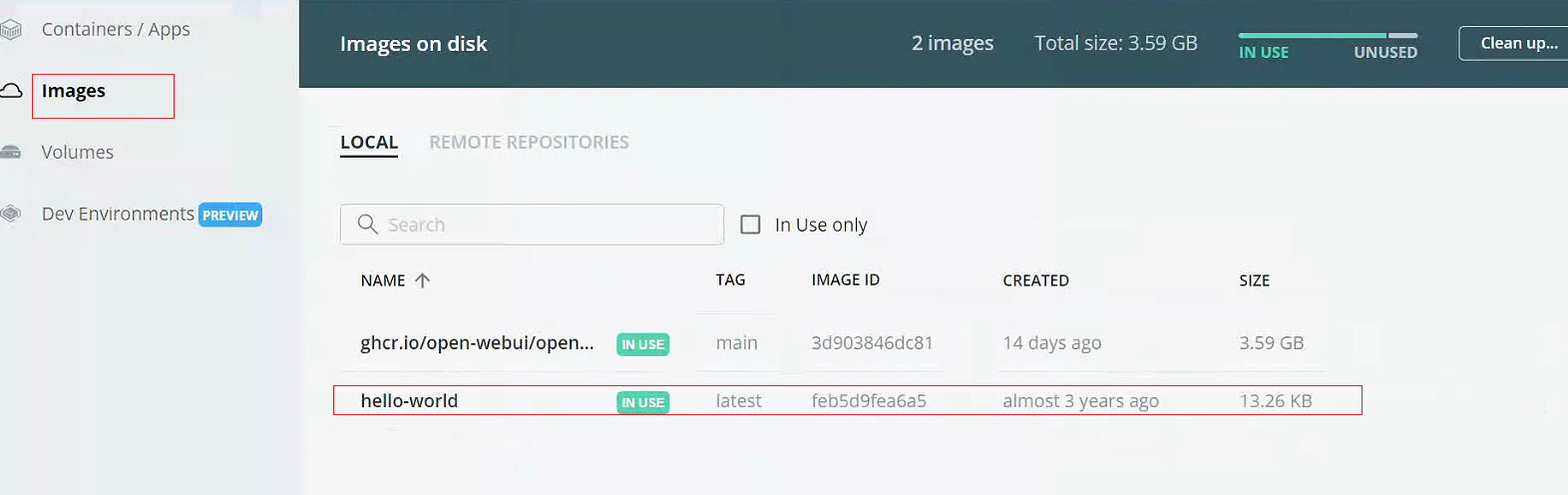

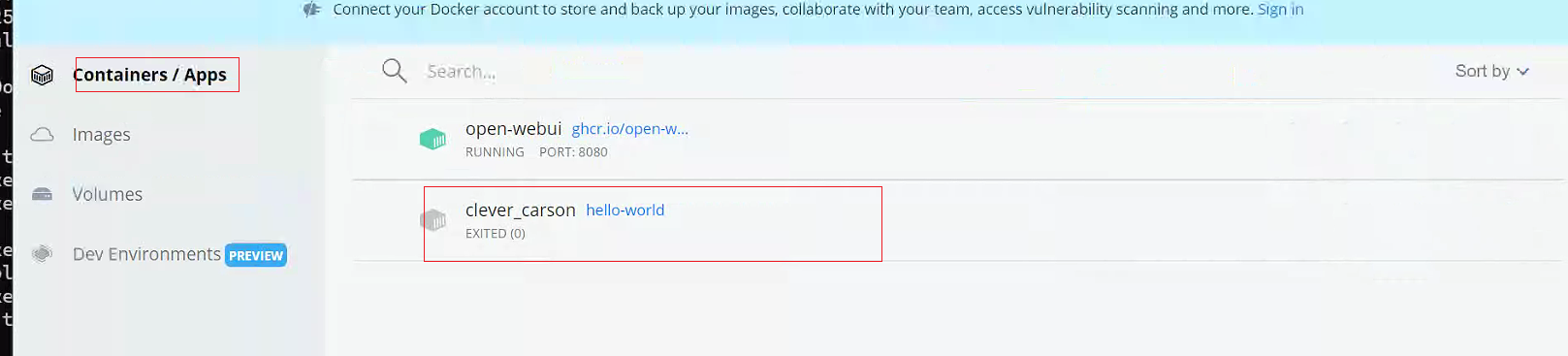

查看docker desktop会看到hello-world镜像和实例,点击可启动:

3.5 安装Open-WebUI

docker安装open-webui即可使用:

docker run --security-opt seccomp:unconfined -p 8080:8080 -e OLLAMA_BASE_URL=http://host.docker.internal:11434 --name open-webui --restart always -v open-webui-data:/app/backend/data ghcr.io/open-webui/open-webui:main

参数说明:

- --security-opt seccomp:unconfined 由于docker desktop版本较低,所以关闭Seccomp保护

- -p 8080:8080 映射本地端口

- -e OLLAMA_BASE_URL=http://host.docker.internal:11434 指定ollama的url地址

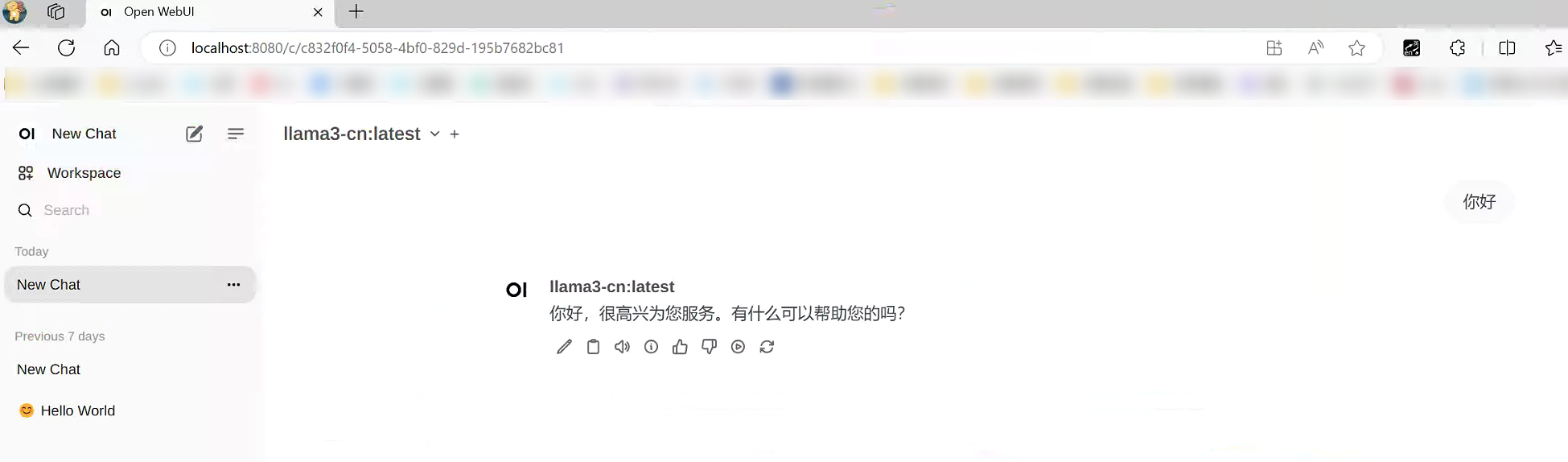

安装之后访问 http://localhost:8080 即可访问本地部署的大模型:

第一次登陆注册的是管理员账号:

1142262478@qq.com

password

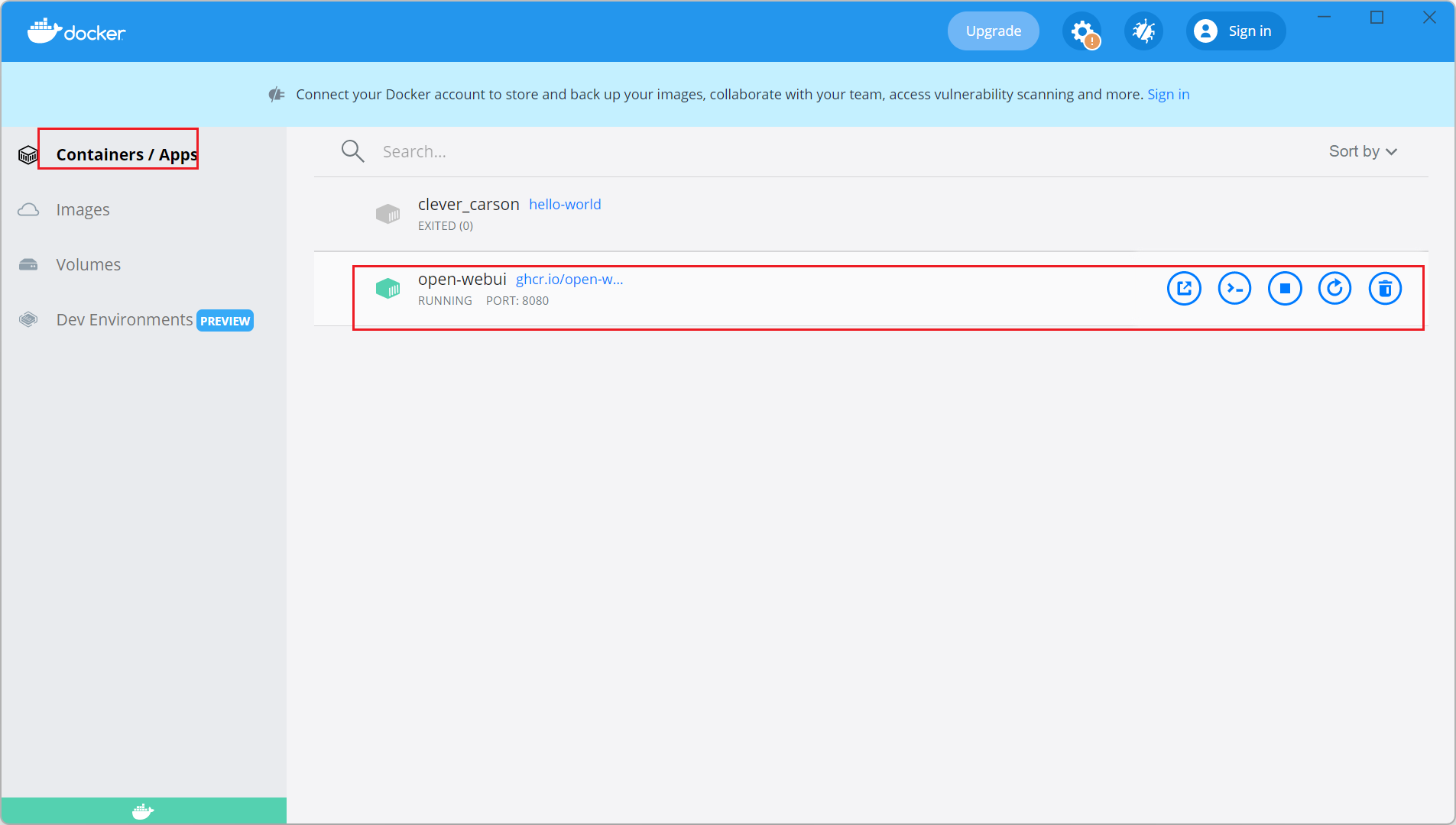

以后可以在docker desktop启动、管理open-webui: